如何构建可信赖的AI系统

图片来源于网络,如有侵权,请联系删除

编者按 当前,人工智能发展方兴未艾,大幅提升了人类认识世界和改造世界的能力,同时也带来一系列难以预知的风险挑战。为帮助读者更好了解人工智能,本版今起推出“解读人工智能前沿技术趋势”系列报道,分析技术变革深层逻辑,凝聚智能向善共识。

近期,国内外一些人工智能(AI)产品问答内容价值导向错误的新闻频上热搜。随着AI技术的发展,AI的价值导向问题逐渐引发广泛关注,“构建可信赖的AI系统”的呼声越来越高。日前在2024年世界科技与发展论坛期间发布的《2024年人工智能十大前沿技术趋势展望》,就列入了“人机对齐:构建可信赖的AI系统”。2024年世界互联网大会乌镇峰会也聚焦AI,释放清晰信号——拥抱以人为本、智能向善的数字未来。

什么是可信赖的AI系统?构建可信赖的AI系统有哪些路径?记者就以上问题采访了相关专家。

可靠稳定是关键

随着AI在社会生活和各个行业中渗透程度的加深,其决策和行为的影响范围也日益扩大。例如,在医疗、交通、金融等高风险领域,AI系统的决策影响着人们的生命、财产与福祉,一些错误决策可能直接威胁到人类生命或财产安全。康奈尔大学约翰逊商学院讲席教授丛林介绍,AI在金融领域的应用主要包括资产管理、资产回报预测、资产定价等。“我们希望金融领域的AI要准确。我们并不需要它有发散思维或特别有创造力,而是希望它能给我们准确的答案,或是具有一定的稳健性。”他说。

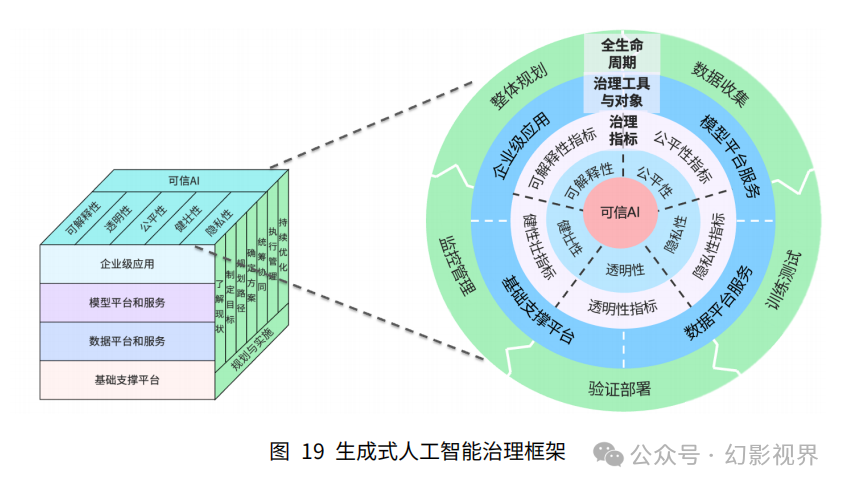

“确保AI系统可信赖,已经成为AI发展不可忽视的要求。这不仅是技术层面的改进,更是社会伦理与责任的体现。”中国科学技术大学人工智能与数据科学学院教授王翔认为,可信赖AI系统不仅能让技术更好地满足人类需求,还能有效防范AI误判和偏见可能引发的负面效应。可信赖的AI系统不但要有优秀的预测、生成、决策等业务能力,而且在透明度、公平性、可解释性、安全性等方面也要符合用户预期。

其中,可解释性是指用户应能够理解AI的行为和决策流程,以便增强用户对AI的信任,并更好地加以利用。公平性要求AI的决策不应受到偏见影响,避免形成对不同群体的歧视。安全性则是指AI系统在运行过程中不会带来安全隐患,并能在一定范围内控制自身行为,特别是在极端或意外情况下要能保护人类安全。“AI系统还需要具备可靠性和稳定性,这要求它的表现在复杂和变化的开发环境中也要始终如一,不轻易受到外部因素干扰。”王翔说。

人机对齐是前提

那么,如何确保AI系统可信赖?王翔认为,人机对齐与构建可信赖的AI系统之间关系密切。“只有具备人机对齐特质的AI系统,才能进一步实现可信赖的特性。”他说。

从概念上看,人机对齐是指确保AI系统在执行任务、进行决策时,其行为、目标和价值观能够与人类保持一致。“这就是说,AI系统在自我优化和执行任务过程中,不仅要高效完成任务,还要符合人类的伦理和价值体系,不能偏离人类设定的目标或带来不良的社会影响。”王翔进一步解释,“尤其是在涉及社会伦理和安全的场景中,确保AI输出内容与人类的价值观和道德准则相符,是人机对齐的核心意义。”

如果AI系统没有经过人机对齐的过程,即使具备强大的功能和智能,也可能因不符合人类的期望和价值观而导致信任危机或负面影响。“因此,确保AI系统在目标和行为上与人类保持一致是构建可信赖AI系统的重要前提。两者的结合不仅能提升AI的表现,还可为未来AI在各领域的广泛应用奠定基础。”王翔说。

确保AI以人为本、智能向善,完善伦理和法律框架是重要发力方向。王翔认为,技术的进步往往伴随着新问题的发生,因此需要设立法律边界和伦理准则,为AI的发展提供指导与约束。这不仅可以减少AI应用中潜在的伦理风险,还能使AI应用更加规范和安全。此外,建设可信赖的AI系统需要跨学科合作,哲学、伦理学、社会学等学科的参与能为AI的设计与发展提供更全面的视角。

技术优化是手段

构建可信赖的AI系统,还需要在技术层面和应用实践中不断探索和完善。王翔介绍了三种主要的技术路径。

一是数据驱动路径。王翔认为,数据质量和多样性是实现可信赖AI的基础。训练数据的多样性可以有效减少模型中的偏见问题,确保系统决策更加公平、全面。“只有在庞大的优质数据基础上构建的AI模型才能适应广泛的应用场景,降低在特殊或极端条件下出现偏见的可能性。”王翔说,数据的安全性也至关重要,尤其是在涉及个人隐私的领域,保障数据安全可以提高用户信任度。

二是算法驱动路径。王翔说,算法的优化与控制是实现可信赖AI的关键手段。在模型的设计阶段,开发者可以通过设置伦理规则、嵌入人类价值观等约束条件,确保系统在实际运行中符合社会准则。同时,设计透明的算法结构有助于提升模型的可解释性,便于用户理解其运行机制,并为未来的模型更新和优化打下基础。

三是奖惩引导路径。王翔说,通过合理设计奖惩机制,可以让AI在不断试错和学习过程中,逐渐形成符合人类价值观的行为方式。例如,可以在奖惩系统中设置反馈机制,当AI的行为偏离预期时施加相应惩罚,引导其在自我训练过程中符合人类期望。同时,奖惩机制需具备时代适应性,确保AI系统能在运行中持续更新并优化自身。

这三种技术路径的侧重点各有不同。王翔解释,数据驱动路径主要聚焦于通过高质量、多样化的数据源减少AI系统的偏见,提升系统的适用性;算法驱动路径更注重模型的设计和透明性,使系统在行为逻辑上更符合人类预期;奖惩引导路径则侧重于在AI自我学习和优化过程中提供有效指引和反馈,让系统逐渐趋向人类认可的方向。“不同路径相结合,可以为实现可信赖的AI提供更加丰富的技术支持。”王翔说。

要构建可信赖的AI系统,还需在实际应用中不断进行迭代和优化。“通过多次评估和测试,可以在不同环境和条件下验证AI系统的性能,确保其在现实应用中的表现符合人类预期。”王翔说。(记者 吴叶凡)

【责任编辑:朱家齐】

版权声明

本文仅代表作者观点,不代表xx立场。

本文系作者授权xxx发表,未经许可,不得转载。