阿里发布新一代基模千问3.5,登顶全球最强开源大模型

图片来源于网络,如有侵权,请联系删除

2月16日除夕当天,阿里巴巴开源全新一代大模型千问Qwen3.5-Plus,性能媲美Gemini 3 Pro,登顶全球最强开源模型。

据悉,千问3.5实现了底层模型架构的全面革新,此次发布的Qwen3.5-Plus版本总参数为3970亿,激活仅170亿,以小胜大,性能超过万亿参数的Qwen3-Max模型,部署显存占用降低60%,推理效率大幅提升,最大推理吞吐量可提升至19倍。Qwen3.5-Plus的API价格每百万Token低至0.8元,仅为Gemini 3 Pro的1/18。

与前几代的千问大语言模型不同,千问3.5实现了从纯文本模型到原生多模态模型的代际跃迁。千问3预训练在纯文本Tokens上进行,而千问3.5则基于视觉和文本混合token上预训练,并大幅新增中英文、多语言、STEM和推理等数据,让张开“眼睛”的大模型学会了更密集的世界知识和推理逻辑,以不到40%的参数量获得超万亿的Qwen3-Max基座模型的顶尖性能,在推理、编程、Agent智能体等全方位基准评估中均表现优异。比如,千问3.5在MMLU-Pro知识推理评测中得分87.8分,超越GPT-5.2;在博士级难题GPQA测评中斩获88.4分,高于Claude 4.5;在指令遵循IFBench以76.5分刷新所有模型纪录;而在通用Agent评测BFCL-V4、搜索Agent评测Browsecomp等基准中,千问3.5表现均超越Gemini 3 Pro、GPT-5.2。

原生多模态训练,也带来千问3.5的视觉能力飞跃:在多模态推理(MathVison)、通用视觉问答VQA(RealWorldQA)、文本识别和文件理解(CC_OCR)、空间智能(RefCOCO-avg)、视频理解(MLVU)等众多权威评测中,千问3.5均斩获最佳性能。在学科解题、任务规划与物理空间推理等任务上,千问3.5相比千问专项模型Qwen3-VL表现更好,空间定位推理和带图推理能力均大幅增强,推理分析更精细、精准;在视频理解方面,千问3.5支持长达2小时(1M token上下文)的视频直接输入,适用于长视频内容分析与摘要生成;同时,千问3.5实现了视觉理解与代码能力的原生融合,结合图搜和生图工具,可将手绘界面草图直接转为可用的前端代码,一张截图就能定位并修复UI问题,让视觉编程真正成为生产力工具。

千问3.5的原生多模态训练,是在阿里云AI基础设施上高效完成的。通过系列基础技术创新,千问3.5在文本、图像、视频等混合数据训练吞吐量,几近100%持平纯文本基座模型训练,大举降低了原生多模态训练的难度门槛;同时,通过设计精巧的FP8、FP32精度应用策略,在训练稳定扩展到数十万亿个token时,激活内存减少约50% ,训练还能提速10% ,进一步节约了模型训练成本、提升了训练效率。

千问3.5也实现了从Agent框架到Agent应用的新突破。千问3.5可自主操作手机与电脑,高效完成日常任务,在移动端支持更多主流APP与指令,在PC端可处理更复杂的多步骤操作,如跨应用数据整理、自动化流程执行等,显著提升操作效率。同时,千问团队构建了一个可扩展的Agent异步强化学习框架,端到端可加速3到5倍,并将插件式智能体Agent支持扩展至百万级规模。

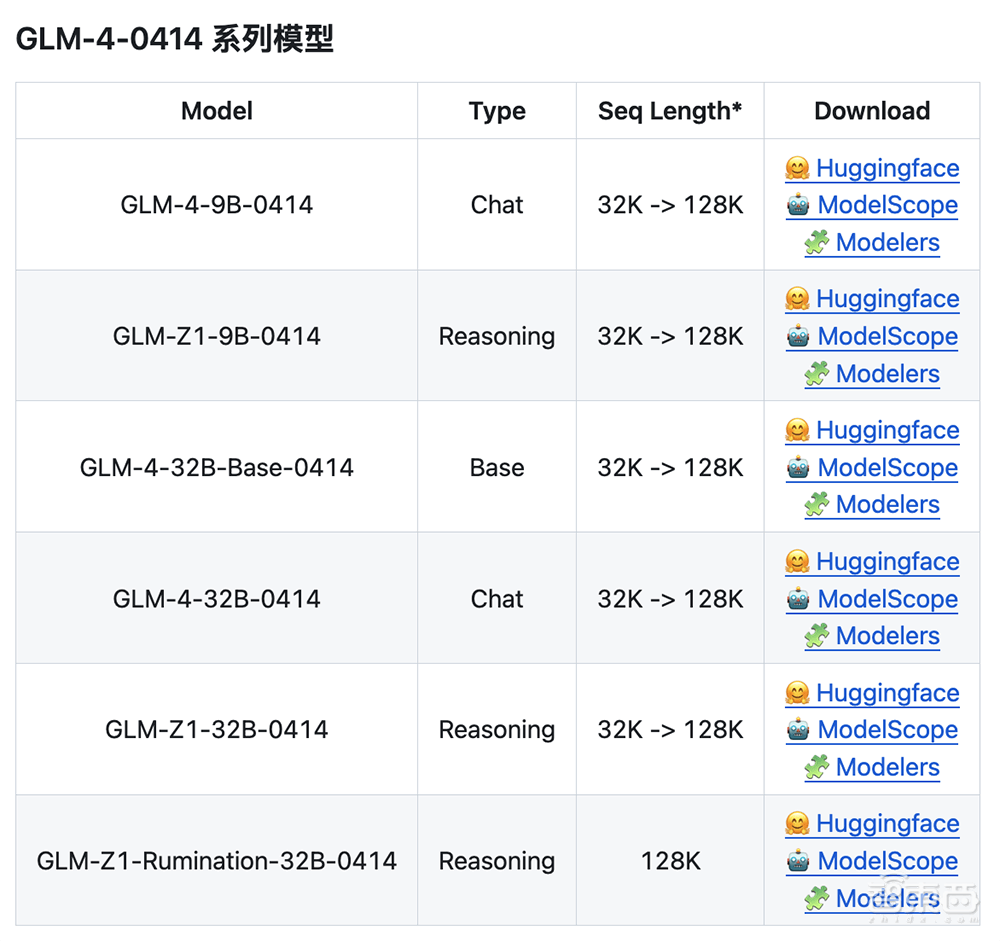

据悉,千问APP、PC端已第一时间接入Qwen3.5-Plus模型。开发者可在魔搭社区和HuggingFace下载新模型,或通过阿里云百炼直接获取API服务。阿里很快将继续开源不同尺寸、不同功能的千问3.5系列模型。性能更强的旗舰模型Qwen3.5-Max不久也将发布。

版权声明

本文仅代表作者观点,不代表xx立场。

本文系作者授权xxx发表,未经许可,不得转载。